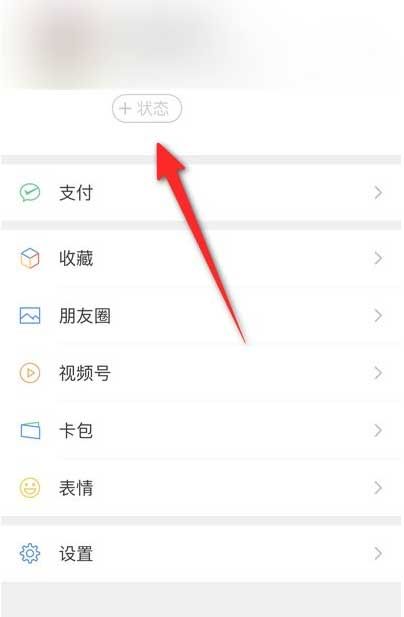

Q:国内外的搜索引擎市场格局会受到ChatGPT多大的影响?

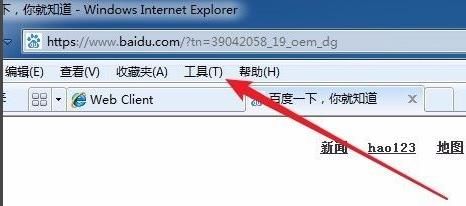

A:传统搜索引擎以链接罗列方式向终端客户提供信息,而ChatGPT通过AIGC对信息进行二次加工并提供唯一答案,两者责任主体有所不同。Bing推出的整合产品提供信息时附带了信息来源,但仍未改变责任主体已悄然转移至搜索引擎的事实,细节仍需继续推敲。百度、搜狗、360等公司即使相比微软有后发劣势,但在国内大环境下有一定政策优势。从全球格局来看,ChatGPT对搜索引擎的格局肯定会有影响,但很难打破谷歌全球市占率90%的龙头地位。尽管微软Bing具有先发优势,其目前全球市占率3%-4%左右,落后谷歌较多。

Q:ChatGPT对国内搜索引擎市场格局的冲击是否会更大? A:和国外市场相比,Bing国内市场份额可能会有所增加。但Bing搜索的目标客户主要集中在科技从业者、一二线城市用户等专业人士群体,可能发生使用转移,但对三四线城市等大多数群体来说更多使用手机内嵌的搜索引擎,影响相对有限。

Q:如何看待围绕ChatGPT的智联网产业的机会?

A:要将ChatGPT进一步大规模应用,将有三方面起到决定作用:1)与行业深度结合的能力。金融科技、数字政务等领域拥有巨大数据量,类ChatGPT技术要实现以上领域的发展必须在行业数据、业务流程等方面做深度的信息结合与应用。2)完善的用户、渠道、伙伴生态环境。生态决定产品占领市场的速度与渗透程度。3)技术与产品化能力。算法是没有边界的,而模型是有边界的。具体结合应用的过程中,不同领域公司有各自优势。搜索引擎拥有信息搜索入口的大量用户优势,苹果siri等智能终端与ChatGPT结合后将大幅提升沉浸式交互体验,对于安防厂商来说,将类ChatGPT能力整合原有软硬件产品也将带来一定优势。

(资料图片)

(资料图片)

Q:现有厂商在将ChatGPT接口与原有产品整合的过程中,会遇到哪些难点? A:举例来说,厂商通过文本输入方式与ChatGPT产生交互,但在面对银行网点的智能化改造过程中,用户只能通过语音进行交互,且若无网环境、嘈杂环境、多人发声环境均会造成难点。国内阿里、讯飞等基础的智能语音产品目前识别准

确率已经达到90%,但对于落地场景中的普通用户来说只要求“对答如流,零答非所问”。此时厂商需要对语音识别中99%以上错误进行纠错,同时满足不同方言口音需求等障碍。要实现终端智能设备能力的大幅度提升,项目方与技术提供方均需要有足够的耐心,目前市场环境中往往实际效果与期待有所差距,主要原因为人工智能及智能科技落地相关领域人才的缺乏。

Q:OpenAI在ChatGPT方向生态合作的模式与未来变化?

A:目前包括百度、阿里等布局算法的厂商商业模式可以分为两种:1)按照调用次数或设备授权数向企业与开发者提供API或SDK。2)面向C端客户,将技术工具化,进行图表处理、文案编辑等相关服务。对开发者来说,在政策许可情况下结合实际环境做结合与开发。

在技术应用方面,有以下几类大方向:1)提高搜索引擎获取信息效率。2)在操作系统方面增强沉浸式交互能力,以键盘鼠标为代表的的传统图形操作界面已渐渐无法满足人工智能时代的需要。3)目前文本、图片等信息密度越来越高,将用于Siri、小度等个人智能助手用于解放个人用户脑力,其中可包括大量个性化定制需求。4)与各行业进行合作提升企业服务能力。5)物联网终端,软件交互载体需要依托终端对用户进行交互。

Q:对于B端合作伙伴,ChatGPT是否会有保留的开放其AI能力?

A:可能性存在但是较小。例如对于安防厂商来说,与ChatGPT签订合约,拿到金融行业数据后是否训练出色,关键在于企业是否对实际应用中的行业业务十分熟悉。

目前三大系列语言模型Bard、GPT、XLNet均基于transform预训练方式,且相关论文及开源框架均在网络公开。ChatGPT从GPT3.0演变而来,但不断增强了用户反馈机制,依靠大量人力进行堆积从量变到质变。基础算力投入不需要特别大,投入400-500块左右A100,共计投入400万-1000万美金,算力即可满足基础训练要求。难点在于大量的数据采集、数据反馈过程中涉及到大量数据标注、评分评价、大量研发人员的投入,涉及到大几千万到上亿美金投入。而此前

ChatGPT在众多厂商脱颖而出在于其他厂商相对较为功利化,而目前对于训练

结果有了预期,费用变得可承担可评估,会有进一步发展。相比自己开发模型,借助ChatGPT现有模型进行商业变现受到的限制会较多。

Q:如何看待微软全线产品叠加ChatGPT能力对国内市场影响?

A:微软操作系统、Office等类工具软件叠加ChatGPT能力后将提高工具效率,有概率对国内办公软件、云工具软件等相关产品竞争厂商造成用户回流等影响。

Q:如何展望ChatGPT后续的政策及产业演进?

A:政策方面,有望出台相关鼓励政策推动产业发展。未来半年到一年内,

ChatGPT技术会在众多细分领域中出现标杆产品,且相关算法企业会推出自己的类ChatGPT产品,包括OpenAI的GPT-4的推出。在多模态增强方面,未来有机会不仅局限于文本交互,将通过语音、视觉等方式进行仿人类的产品交互。

Q:模型样本的人工标注方式是否会向机器方式变化,是否对模型迭代速度产生影响?

A:预训练是算法模型中很重要的一个环节。在AIGC模型预训练中,相对同一个问题准备足够多的人员保证答案的多样性与丰富度十分重要。虽然此过程看似笨拙, 但在库完善过后剩余均为机械过程, 反而更为高效。举例来说,

ChatGPT模型从未接触过在银行具体业务进行过程中产生的数据,故在具体柜台业务应用的过程中,模型均需要针对业务数据进行较为短期的小样本增量训练并进行部署,此过程不需要人工参与。此前的人工内容准备训练过程则较为繁琐,需要大量人工参与大样本训练。例如ChatGPT本身训练数据为2021年之前数据,但Bing将其整合之后用户可以体验到最新数据结果,此类训练即为增量训练,数据抓取过来进行短期训练即为可用,

Q:生态合作伙伴在做模型选择时,比如ChatGPT、Bard、百度文心等,会考虑哪些因素?

A:会选择自定义范围更大的模型作为基础进行改进。例如ChatGPT在仿人交互方面仍有不足,举例来说,面对喝什么咖啡的问题,ChatGPT会直接给出答案,但实际生活中人类会对咖啡厅位置、咖啡种类进行评估,ChatGPT仍旧缺

少部分人类逻辑与习惯,未来希望其自主能用性能够再上一个台阶。国内现阶段,GPT、Bard系列均有厂商进行使用,在国外其实已经各领风骚了很长一段时间。国内和国外目前主要的差距在于响应速度,其背后原因在于服务部署与高并发访问支持,相对来说不属于技术瓶颈,只是需要精力成本进行布局。要支持百万级与千万级的并发,需要进行服务器集群、负载均衡、网络安全等部署,每年花费在0.60-0.70亿元以上。

Q:如何看待ChatGPT参数量增长与硬件需求关系?

A:参数量会有增长但不会增长太快。下一代ChatGPT主要增强多模态能力,例如音频视频处理等方面对算力投入要求会比文本生成大很多,对GPU、CPU需求会有成倍增长,但需求产生要求来自于多模态能力而不是参数增加。

Q:通过增加参数量,可以使模型获得更好处理长文本的能力吗?

A:目前ChatGPT的缺陷来自于其有限的商业模式,OpenAI通过API、SDK、会员订阅等方式产生的收入与其实际投入不成正比且有限,且谷歌等大厂会进一步推出其产品压缩市场空间,其仍然有待于通过ChatGPT技术作为内核研发更高附加价值的产品进行商业变现。